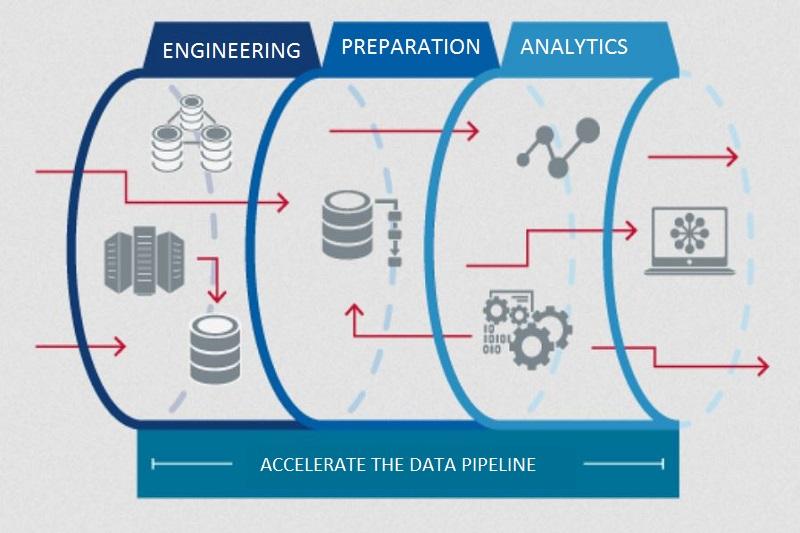

در یک Data Pipeline، دادهها معمولا از منابع مختلف مانند پایگاههای داده، فایلها، سرویسهای وب و سایر منابع جمعآوری میشوند. سپس، این دادهها به صورت خودکار در مراحل مختلفی مانند تبدیل، تحلیل، پاکسازی و ترکیب دادهها پردازش میشوند. در نهایت، دادهها به سیستم مورد نظر انتقال داده میشوند تا برای استفاده در برنامههای کاربردی و سایر سیستمها موجود قرار گیرند. استفاده از Data Pipeline در سازمانها، میتواند به بهبود کارایی و دقت در جمعآوری و پردازش دادهها و به کاهش زمان و هزینه مورد نیاز برای پردازش دادهها کمک میکند.

چه نوع ابزارهایی برای پیادهسازی Data Pipeline وجود دارد؟

برای پیادهسازی Data Pipeline، مجموعهای از ابزارها و فرآیندهای مختلف وجود دارد که به شما کمک میکنند تا بتوانید از دادههای خود به بهترین شکل ممکن استفاده کنید. برخی از این ابزارها عبارتند از:

- Apache NiFi: یک ابزار منبع باز برای ایجاد و مدیریت Data Pipeline است. این ابزار امکان کنترل و پیگیری دادهها را از طریق یک رابط گرافیکی کاربری ساده فراهم میکند.

- Apache Kafka: یک سیستم پیامرسانی توزیعشده برای انتقال دادهها و رویدادها بین سیستمها است. این ابزار امکان تحویل داده با سرعت بالا و اطمینان بالا را فراهم میکند.

- Apache Spark: یک فریمورک توزیع شده برای پردازش دادههای بزرگ است. این ابزار امکان پردازش دادههای بلادرنگ و دستهای و همچنین پشتیبانی از انواع مختلف دادهها را فراهم میکند.

- AWS Data Pipeline: یک سرویس مدیریت Data Pipeline برای استفاده در Amazon Web Services است. این سرویس امکان ایجاد و مدیریت Data Pipeline برای انتقال و پردازش دادهها در محیط AWS را فراهم میکند.

- Microsoft Azure Data Factory: یک سرویس مدیریت Data Pipeline برای استفاده در محیط Microsoft Azure است. این سرویس امکان ساخت، مدیریت و پیادهسازی Data Pipeline را برای انتقال و پردازش دادهها در محیط Azure فراهم میکند.

- Google Cloud Dataflow: یک سرویس پردازش داده توزیع شده برای استفاده در Google Cloud است. این سرویس امکان پردازش دادههای Real-Time و Batch و همچنین پشتیبانی از انواع مختلف دادهها را فراهم میکند.

به علاوه، ابزارهایی مانند Apache Airflow، Talend، StreamSets و Pentaho نیز به عنوان ابزارهای مدیریت Data Pipeline وجود دارند. هر کدام از این ابزارها دارای ویژگیها و قابلیتهای مختلفی هستند که بسته به نیاز و شرایط پروژه، میتوانید از آنها استفاده کنید.

چگونه میتوان خطوط انتقال دادهها را بهینهسازی کرد؟

برای بهینهسازی خطوط انتقال دادهها و به دست آوردن عملکرد بهتر، میتوانید از رویکردهای مختلفی استفاده کنید. در زیر به چند رویکرد مهم برای بهینهسازی خطوط انتقال دادهها اشاره میکنم:

- تحلیل نیازمندیها: برای بهینهسازی خطوط انتقال دادهها، ابتدا باید نیازمندیهای مربوط به پردازش دادهها را به دقت تحلیل کنید. بررسی نیازمندیها به شما کمک میکند تا بهترین راهحل را برای پردازش دادهها پیدا کنید و به طور کلی عملکرد خطوط انتقال دادهها را بهبود دهید.

- مدیریت منابع: مدیریت منابع، شامل منابع سختافزاری و نرمافزاری است. برای بهینهسازی خطوط انتقال دادهها باید از منابع سختافزاری و نرمافزاری مناسب استفاده کنید تا پردازش دادهها با سرعت بالا و به صورت موثر انجام شود.

- بهینهسازی الگوریتمها: الگوریتمهای پردازش دادهها باید به گونهای بهینهسازی شوند که سرعت پردازش دادهها افزایش یابد و مشکلات مربوط به حجم بزرگ دادهها را کاهش دهند.

- استفاده از فناوریهای بلادرنگ: اگر پردازش دادهها برای برنامههای بلادرنگ مورد استفاده قرار میگیرد، باید از فناوریهای بلادرنگ مانند Apache Kafka و Apache Spark Streaming استفاده کنید تا تحلیل دادهها در زمان واقعی انجام شود.

- نگهداری و بهروزرسانی خطوط انتقال دادهها: برای بهینهسازی خطوط انتقال دادهها باید منابع نگهدارنده اطلاعات را بهروز نگه دارید و با استفاده از روشهای مختلفی مانند مانیتورینگ، گزارشها و ابزارهای مشابه، عیبیابی را انجام دهید تا هرگونه مشکلی شناسایی شده و عملکرد خطوط انتقال دادهها بهبود پیدا کند.

- استفاده از راهحلهای ابرمحور: راهحلهای ابرمحور مانند AWS Data Pipeline، Azure Data Factory و Google Cloud Dataflow میتوانند به شما کمک کنند تا عملکرد خطوط انتقال دادهها را بهبود دهید، هزینههای مربوط به سختافزار را کاهش دهید و پایداری را افزایش دهید.

در کل، بهینهسازی خطوط انتقال دادهها نیازمند تحلیل دقیق نیازمندیها، مدیریت منابع، بهینهسازی الگوریتمها و استفاده از روشهای مختلفی برای نگهداری و بهروزرسانی خطوط انتقال دادهها است.

آیا خطوط انتقال دادهها برای تمامی سازمانها مناسب است؟

خطوط انتقال دادهها برای اکثر سازمانها ضروری است، اما میزان مناسب بودن آن بستگی به نیازهای ویژه هر سازمان دارد. برای سازمانهایی که با حجم بزرگی از دادهها سروکار دارند، خطوط انتقال دادهها بسیار حیاتی است. به بیان دقیقتر، شرکتهای بزرگ فناوری، شرکتهای بانکی، شرکتهای بیمه، شرکتهای حمل و نقل و غیره به خطوط انتقال دادهها نیاز دارند.

با استفاده از خطوط انتقال دادهها، سازمانها میتوانند دادهها را در یک محیط متمرکز و مدیریت شده، به صورت بلادرنگ یا دستهای پردازش کنند و از آنها برای تحلیل دقیق و تصمیمگیریهای بهتر استفاده کنند. همچنین، با استفاده از خطوط انتقال دادهها میتوانید هزینههای پردازش دادهها را کاهش داده و بهبود عملکرد سیستم خود را تجربه کنید.

اگرچه خطوط انتقال دادهها برای بهبود فعالیتهای تجاری بسیاری از سازمانها ضروری است، اما سازمانهای کوچک و متوسط باید به این نکته دقت کنند که پیادهسازی خطوط انتقال دادهها ممکن است هزینههایی مربوط به سختافزار و نرمافزار، هزینههای توسعه و نگهداری و غیره را برای آنها به همراه داشته باشد. بنابراین، در این شرایط ممکن است نیاز به استفاده از راهکارهای دیگری به جای خطوط انتقال دادهها مفید باشد.

چگونه Data pipeline را ایجاد کنیم؟

فرآیند ساخت خطوط انتقال دادهها مستلزم پشت سر گذاشتن مراحل مختلفی است که از مهمترین آنها به موارد زیر باید اشاره کرد:

- تحلیل نیازمندیها: برای ایجاد خطوط انتقال دادهها، باید نیازمندیهای مربوط به پردازش دادهها را به دقت تحلیل کنید. این شامل تعریف منابع مورد نیاز، فرایندهای پردازش دادهها، الگوریتمهای مورد استفاده و غیره میشود.

- تعیین منابع سختافزاری: بعد از تحلیل نیازمندیها، باید منابع سختافزاری مورد نیاز برای پردازش دادهها را تعیین کنید. این شامل تعیین تعداد سرورها، پردازندهها، حافظهها، دیسکها و غیره است.

- انتخاب ابزارهای مورد نیاز: برای ایجاد خطوط انتقال دادهها باید از ابزارهای مختلفی مانند Apache Kafka، Apache Spark، Hadoop، Apache NiFi و غیره استفاده کنید. برای انتخاب بهترین ابزارها، باید فرایندهای پردازش دادهها، میزان دادهها و محدودیتهای دیگر را در نظر بگیرید.

- طراحی و پیادهسازی خطوط انتقال دادهها: بعد از تعیین نیازمندیها، منابع سختافزاری و ابزارهای مورد نیاز، باید فرایند طراحی و پیادهسازی خطوط انتقال دادهها را آغاز کنید. در این مرحله، باید مراحل پردازش دادهها، ارتباط بین سرویسهای مختلف و ساختار دادهها را شناسایی کرده و پیادهسازی کنید.

- تست و ارزیابی: بعد از پیادهسازی خطوط انتقال دادهها باید آن را تست و ارزیابی کنید. باید مطمئن شوید که فرایندهای پردازش دادهها به درستی انجام میشود و دادههای خروجی درست و کارآمد هستند.

- نگهداری و بهبود: بعد از راهاندازی خطوط انتقال دادهها باید آن را نگهداری و بهبود دهید و از طریق ارزیابی مستمر مشکلات را شناسایی و برطرف کنید.

در کل، ایجاد خطوط انتقال دادهها نیازمند تحلیل دقیق نیازمندیها، تعیین منابع سختافزاری، انتخاب ابزارهای مناسب، پیادهسازی و تست و بهبود مستمر آن است.

زبانهای برنامهنویسی مناسب برای ساخت خطوط انتقال دادهها

برای پیادهسازی خطوط انتقال دادهها میتوانید از زبانهای برنامهنویسی مختلفی استفاده کنید. در ادامه به برخی از زبانهایی که برای پیادهسازی خطوط انتقال دادهها مناسب هستند، اشاره میکنیم:

- Python: پایتون یکی از محبوبترین زبانهای برنامهنویسی است که برای پیادهسازی خطوط انتقال دادهها بسیار مناسب است. پایتون دارای کتابخانههای متعددی برای پردازش و تحلیل دادهها است که از جمله آنها میتوان به Pandas، NumPy، SciPy، Scikit-learn و TensorFlow اشاره کرد.

- Java; جاوا یک زبان برنامهنویسی قدرتمند است که برای پیادهسازی خطوط انتقال دادهها مناسب است. Apache Hadoop و Apache Spark از جمله پروژههایی هستند که از جاوا برای پیادهسازی خطوط انتقال دادهها استفاده میکنند.

- Scala: اسکالا یک زبان برنامهنویسی جدید است که برای پیادهسازی خطوط انتقال دادهها بسیار مناسب است. Apache Spark از جمله پروژههایی است که با استفاده از Scala پیادهسازی شده است.

- SQL: یک زبان پرسوجو است که برای پردازش دادهها در پایگاهدادهها به کار میرود. اسکیوال دارای قابلیتهایی برای پردازش دادههای بزرگ و توزیعشده است.

- Go: یک زبان برنامهنویسی سریع و قابل اطمینان است که برای پیادهسازی خطوط انتقال دادهها مناسب است. زبان Go دارای قابلیتهایی برای پردازش دادههای بزرگ است.

در کل، انتخاب زبان برنامهنویسی مناسب برای پیادهسازی خطوط انتقال دادهها بستگی به نیازمندیها و منابع مورد نیاز دارد. اما از آنجایی که پایتون و جاوا بسیار محبوب هستند و به عنوان زبانهای اصلی برای پیادهسازی خطوط انتقال دادهها مورد استفاده قرار میگیرند، پیشنهاد میشود که با استفاده از این دو زبان شروع به پیادهسازی خطوط انتقال دادهها کنید.

ماهنامه شبکه را از کجا تهیه کنیم؟

ماهنامه شبکه را میتوانید از کتابخانههای عمومی سراسر کشور و نیز از دکههای روزنامهفروشی تهیه نمائید.

ثبت اشتراک نسخه کاغذی ماهنامه شبکه

ثبت اشتراک نسخه آنلاین

کتاب الکترونیک +Network راهنمای شبکهها

- برای دانلود تنها کتاب کامل ترجمه فارسی +Network اینجا کلیک کنید.

کتاب الکترونیک دوره مقدماتی آموزش پایتون

- اگر قصد یادگیری برنامهنویسی را دارید ولی هیچ پیشزمینهای ندارید اینجا کلیک کنید.

نظر شما چیست؟