عملکرد طبقهبندی کننده بیز بومی بر اساس قاعده بیز است که به شرح زیر است:

P(Y|X) = (P(X|Y) * P(Y)) / P(X)

در این فرمول، Y نشان دهنده کلاس است که میخواهیم داده را در آن کلاس بندی کنیم و X برداری از ویژگیهای داده است. P(Y|X) احتمال شرطی کلاس Y به شرط داشتن بردار ویژگی X است. P(X|Y) احتمال شرطی بردار ویژگی X به شرط کلاس Y و P(Y) احتمال پیشین کلاس Y است. P(X) نیز ثابت است و معمولاً در روشهای طبقهبندی کننده بیز بومی حذف میشود زیرا تاثیری در تصمیمگیری ندارد.

برای آموزش طبقهبندی کننده بیز بومی، ابتدا باید احتمال شرطی P(X|Y) و احتمال پیشین P(Y) را برای هر کلاس محاسبه کنیم. سپس با استفاده از فرمول بیز، احتمال شرطی کلاس به شرط داشتن بردار ویژگی را محاسبه کرده و داده را در کلاسی قرار میدهیم که احتمال شرطی آن بیشتر است.

طبقهبندی کننده بیز بومی به دلیل سادگی و سرعت بالا در آموزش و پیشبینی، استفاده گستردهای در حوزههای مختلف از جمله پردازش زبان طبیعی، تشخیص هرزنامه، تحلیل متن، سیستمهای توصیه و بسیاری از برنامههای دیگر دارد. با این حال، یکی از محدودیتهای طبقهبندی کننده بیز بومی این است که فرض استقلال ویژگیها ممکن است در برخی موارد نادرست باشد و باعث کاهش دقت پیشبینی شود.

آیا Naive Bayes Classifier میتواند با دادههای پیوسته نیز کار کند؟

بله، طبقهبندی کننده بیز بومی قابلیت کار با دادههای پیوسته (continuous) را دارد. در حقیقت، برای دادههای پیوسته، از نمونهبرداری از توزیعهای احتمالی مختلف استفاده میکند.

برای استفاده از طبقهبندی کننده بومی با دادههای پیوسته، معمولا از تخمینگرهای احتمالی مانند تخمینگر گاوسین (Gaussian estimator) استفاده میشود. در این حالت، فرض میشود که ویژگیها در هر کلاس از توزیع گاوسی پیروی میکنند.

با استفاده از تخمینگر گاوسی ، احتمال شرطی P(X|Y) برای ویژگیهای پیوسته محاسبه میشود. این تخمینگر معمولا با استفاده از میانگین و واریانس ویژگی در هر کلاس محاسبه میشود. سپس با استفاده از فرمول بیز، احتمال شرطی کلاس به شرط داشتن بردار ویژگی برای هر کلاس محاسبه میشود و داده در کلاسی قرار میگیرد که احتمال شرطی آن بیشتر است.

بنابراین، با استفاده از تخمینگر گاوسی و توزیعهای گاوسی، طبقهبندی کننده بیز بومی میتواند با دادههای پیوسته کار کند و بتواند آنها را به درستی کلاسبندی کند.

چه روشهایی برای محاسبه احتمال شرطی P(X|Y) در Naive Bayes Classifier وجود دارد؟

در طبقهبندی کننده بیز بومی چندین روش برای محاسبه احتمال شرطی P(X|Y) وجود دارد که بسته به نوع ویژگیها مورد استفاده قرار میگیرند. برخی از روشهای معمول برای محاسبه احتمال شرطی عبارتند از:

- تخمینگر گاوسین (Gaussian Estimator): این روش برای ویژگیهای پیوسته (continuous) استفاده میشود. در این روش، فرض میشود که ویژگیها در هر کلاس از توزیع گاوسی پیروی میکنند. احتمال شرطی به عنوان تابع توزیع گاوسی با استفاده از میانگین و واریانس محاسبه میشود.

- تخمینگر چندجملهای (Multinomial Estimator): این روش برای ویژگیهای گسسته (discrete) مانند کلمات در پردازش زبان طبیعی استفاده میشود. در این روش، احتمال شرطی به عنوان تعداد ظاهر شدن ویژگی در هر کلاس تقسیم بر تعداد کل ویژگیهای هر کلاس محاسبه میشود.

- تخمینگر برنولی (Bernoulli Estimator): این روش نیز برای ویژگیهای گسسته استفاده میشود، اما در اینجا ویژگیها به صورت دودویی (به وجود آمدن یا عدم وجود) هستند. در این روش، احتمال شرطی به عنوان تعداد بارهایی که ویژگی در هر کلاس ظاهر میشود تقسیم بر تعداد کل نمونههای هر کلاس محاسبه میشود.

استفاده از هر یک از این روشها بسته به نوع ویژگیها و ماهیت مسئله مورد استفاده قرار میگیرد. همچنین، میتوان از روشهای دیگری مانند تخمینگرهای کرنلی (Kernel Estimators) و روشهای دیگر نیز برای محاسبه احتمالات شرطی استفاده کرد، اما روشهای مذکور از رایجترین روشهای استفاده شده در طبقهبندی کننده بیز بومی هستند.

مثالی از کاربرد طبقهبندی کننده بیز بومی در تشخیص هرزنامه

فرض کنید شما یک سیستم تشخیص اسپم ایمیل دارید و میخواهید برنامهای بنویسید که بتواند بر اساس محتوای یک ایمیل، تشخیص دهد که آیا آن ایمیل اسپم است یا خیر.

برای آموزش مدل بیز محلی، شما نیاز به یک مجموعه داده آموزشی دارید که دارای دو دسته ایمیل هست: ایمیلهای اسپم و ایمیلهای غیر اسپم (همچنین به عنوان ایمیلهای "همخوان" یا "غیر همخوان " شناخته میشوند).

اولین قدم در ساخت مدل بیز محلی استخراج ویژگیهای مرتبط از ایمیلهاست. میتوانید از ویژگیهایی مانند تعداد کلمات، تعداد کلمات اسپم، تعداد کلمات اصلی، و تعداد حروف بزرگ در ایمیل استفاده کنید.

سپس، با استفاده از مجموعه داده آموزشی، مدل فوق را آموزش میدهید. احتمال شرطی P(X|Y) را برای هر ویژگی محاسبه میکنید، که در اینجا X نمایانگر ویژگیها (مانند تعداد کلمات، تعداد کلمات اسپم و غیره) و Y نمایانگر برچسب کلاس (اسپم یا غیر اسپم) است.

وقتی که مدل آموزش دید، شما میتوانید آن را بر روی ایمیلهای جدید اعمال کنید. با استفاده از احتمال شرطی محاسبه شده و قاعده بیز، میتوانید احتمال اسپم بودن ایمیل را محاسبه کنید. سپس، با تعیین یک آستانه (threshold)، میتوانید تصمیم بگیرید که آیا ایمیل به عنوان اسپم تشخیص داده شود یا خیر.

به عنوان مثال، اگر احتمال اسپم بودن ایمیل بیشتر از آستانه مشخص شده باشد، آن ایمیل به عنوان اسپم تشخیص داده میشود، در غیر این صورت به عنوان یک ایمیل غیر اسپم در نظر گرفته میشود.

این یک مثال ساده از کاربرد طبقهبندی کننده بیز محلی در تشخیص اسپم بود. البته، در عمل میتوانید از الگوریتمهای بیشتری مانند اطلاعات متنی، طول خطوط، ویژگیهای متنی خاص و غیره برای بهبود دقت و کارایی مدل استفاده کنید.

طرز کار طبقهبندی کننده بیز بومی به چه صورتی است؟

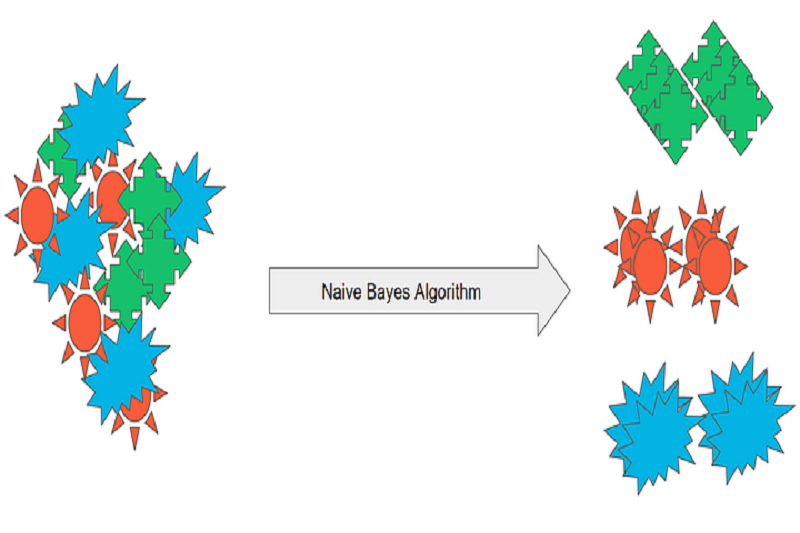

عملکرد طبقهبندی کننده بیز بومی بر اساس استفاده از قاعده بیز برای تصمیمگیری در مورد کلاسها است. عملکرد آن به صورت زیر است:

آموزش مدل:

در مرحله آموزش، ابتدا باید مجموعه داده آموزشی را به عنوان ورودی به مدل بدهید.

مدل بیز بومی با استفاده از مجموعه داده آموزشی، احتمالات شرطی P(X|Y) را برای هر کلاس محاسبه میکند. این احتمالات شرطی نشان میدهند که چقدر ویژگیها (X) در هر کلاس (Y) ظاهر میشوند.

همچنین، مدل باید احتمال آبشاری P(Y) را برای هر کلاس محاسبه کند. این احتمال نشان میدهد که هر کلاس چقدر در مجموعه داده آموزشی حضور داشته است.

پیشبینی برچسب:

وقتی که مدل آموزش دید، میتوانید از آن برای پیشبینی برچسبها در دادههای تست استفاده کنید.

برای هر نمونه تست، مدل احتمالات شرطی P(X|Y) را برای هر کلاس محاسبه میکند.

سپس، با استفاده از قاعده بیز، احتمال شرطی معکوس P(Y|X) را محاسبه میکند. این احتمال نشان میدهد که با توجه به ویژگیهای داده تست، احتمال هر کلاس چقدر است.

برچسبی که احتمال شرطی معکوس آن بیشترین مقدار را دارد، به عنوان برچسب پیشبینی شده برای نمونه تست انتخاب میشود.

عملکرد بیز بومی بسیار سریع است و توانایی خوبی در پردازش دادههای بزرگ دارد. همچنین، با فرض استقلال شرطی ویژگیها، مدل نسبتاً سادهای است که به دلیل کاهش تعداد پارامترها، ممکن است به خوبی عمل کند، به ویژه در مواردی که تعداد ویژگیها زیاد است. با این حال، این فرضیه استقلال شرطی ممکن است در برخی موارد واقعیت را نادیده بگیرد و مدل ممکن است عملکرد مناسبی نداشته باشد.

طبقهکننده بیز بومی چه کاربردی دارد؟

طبقهبندی کننده بیز بومی به عنوان یکی از روشهای محبوب در حوزه یادگیری ماشین و دادهکاوی، کاربردهای متعددی دارد. در زیر تعدادی از کاربردهای مهم آن را بررسی میکنیم:

- تشخیص اسپم: طبقهبندی کننده بیز بومیبرای تشخیص اسپم در ایمیلها و پیامهای متنی استفاده میشود. با آموزش مدل با استفاده از ایمیلهای اسپم و غیر اسپم، مدل میتواند ایمیلهای جدید را به عنوان اسپم یا غیر اسپم تشخیص دهد.

- تحلیل متن: بیز بومی میتواند در تحلیل متن و دستهبندی متن بر اساس موضوعات مختلف مورد استفاده قرار گیرد. با آموزش مدل با استفاده از متنهای دستهبندی شده، مدل میتواند متنهای جدید را به دستههای مختلف تخصیص دهد، مانند دستهبندی خبرها یا تشخیص نظرات مثبت و منفی در شبکههای اجتماعی.

- فیلترهای ضد اسپم: مدل بیز بومی میتواند در فیلترهای ضد اسپم برای تمیز کردن ترافیک ایمیل و پیامهای الکترونیکی استفاده شود. با آموزش مدل با استفاده از نمونههای اسپم و غیر اسپم، مدل میتواند ایمیلهای ناخواسته را شناسایی و فیلتر کند.

- تشخیص بیماریها: بیز بومی میتواند در تشخیص بیماریها و تشخیص خطر ابتلا به بیماریها مورد استفاده قرار گیرد. با آموزش مدل با استفاده از دادههای بیماران مبتلا به بیماری و افراد سالم، مدل میتواند احتمال ابتلا به بیماری را برای افراد جدید محاسبه کند.

- تشخیص تقلب: بیز بومی میتواند در تشخیص تقلب و آشکارسازی الگوهای غیرمعمول در معاملات مالی و کارت اعتباری استفاده شود. با آموزش مدل با استفاده از دادههای معاملات معتبر و معاملات تقلبی، مدل میتواند الگوهای تقلبی را شناسایی کرده و معاملات مشکوک را تشخیص دهد.

موارد یاد شده تنها چند نمونه از کاربردهای Naive Bayes Classifier هستند، هرچند این روش در بسیاری از مسائل دیگر نیز مورد استفاده قرار میگیرد.

یک مثال عملی از طبقهبندیکننده بیز بومی در پایتون

به عنوان مثال، در زیر یک نمونه ساده از استفاده از طبقهبندیکننده بیز بومی در پایتون برای دستهبندی متن را مشاهده میکنید. در این مثال، از کتابخانه scikit-learn استفاده میشود که یکی از پرکاربردترین کتابخانههای ماشین لرنینگ در پایتون است.

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

# دادههای آموزشی

texts = ["I love this movie", "This movie is great", "I dislike this movie", "I hate this movie"]

labels = ["positive", "positive", "negative", "negative"]

# استخراج ویژگیها از متن با استفاده از CountVectorizer

vectorizer = CountVectorizer()

features = vectorizer.fit_transform(texts)

# ساخت مدل ناییو بیز

nb_classifier = MultinomialNB()

nb_classifier.fit(features, labels)

# دادههای تست

test_texts = ["This movie is amazing", "I don't like this film"]

test_features = vectorizer.transform(test_texts)

# پیشبینی برچسبها برای دادههای تست

predicted_labels = nb_classifier.predict(test_features)

# نمایش نتایج پیشبینی

for text, label in zip(test_texts, predicted_labels):

print(f"Text: {text} - Predicted Label: {label}")

این مثال یک مجموعه داده ساده از جملات مربوط به نظرات درباره یک فیلم را دارد. ابتدا دادههای آموزشی به همراه برچسبهای مربوطه تعریف شده است. سپس از CountVectorizer برای استخراج ویژگیهای متن استفاده میشود. سپس یک مدل بیز بومی از نوع MultinomialNB ساخته و با استفاده از دادههای آموزشی آموزش داده میشود. سپس دادههای تست از ویژگیهای متن استخراج شده با استفاده از CountVectorizer تبدیل و برچسبهای مربوطه با استفاده از مدل ناییو بیز پیشبینی میشوند. در نهایت، نتایج پیشبینی برچسبها برای دادههای تست نمایش داده میشوند.

این مثال به طور ساده عملکرد و استفاده از طبقهبندیکننده بیز بومی را نشان میدهد. البته، برای استفاده کامل از طبقهبندیکننده بیز بومی و بهبود عملکرد آن، میتوانید از پیش پردازشهای متنی مانند حذف توقف کلمات، استفاده از TF-IDF و تنظیم پارامترهای مدل استفاده کنید.

چگونه میتوانیم از پیش پردازشهای متنی مانند حذف توقف کلمات و استفاده از TF-IDF برای بهبود عملکرد طبقهبندیکننده بیز بومی استفاده کنم؟

برای بهبود عملکرد طبقهبندیکننده بیز بومی با استفاده از پیش پردازشهای متنی مانند حذف توقف کلمات و استفاده از TF-IDF، میتوانید مراحل زیر را دنبال کنید:

1. حذف توقف کلمات: توقف کلمات کلمات رایجی هستند که به تنهایی ارزش اطلاعاتی زیادی ندارند، مانند "به"، "از"، "در" و غیره. برای حذف توقف کلمات از متن، میتوانید از کتابخانه nltk استفاده کنید. در ابتدا، باید آن را نصب کنید با استفاده از دستور زیر:

pip install nltk

سپس، میتوانید کدهای زیر را به برنامهی خود اضافه کنید:

import nltk

from nltk.corpus import stopwords

# دانلود توقف کلمات

nltk.download('stopwords')

# حذف توقف کلمات از متن

stop_words = set(stopwords.words('english')) # توقف کلمات به زبان انگلیسی

filtered_text = [word for word in text if word not in stop_words]

1. استفاده از TF-IDF: TF-IDF یک روش محاسبه وزن برای هر کلمه در یک مجموعه اسناد است که بر اساس تکرار آن در سند مورد نظر و تکرار آن در بقیه اسناد محاسبه میشود. برای استفاده از TF-IDF در پایتون، میتوانید از کتابخانه scikit-learn استفاده کنید. در ابتدا، باید آن را نصب کنید با استفاده از دستور زیر:

pip install scikit-learn

سپس، میتوانید کدهای زیر را به برنامهی خود اضافه کنید:

from sklearn.feature_extraction.text import TfidfVectorizer

# استخراج ویژگیها با استفاده از TF-IDF

vectorizer = TfidfVectorizer()

features = vectorizer.fit_transform(texts)

با استفاده از کد فوق، میتوانید ویژگیهای متنی را با استفاده از TF-IDF استخراج کنید و به عنوان ورودی به طبقهبندیکننده بیز بومی بدهید.

با استفاده از مراحل بالا، میتوانید عملکرد طبقهبندیکننده بیز بومی را با حذف توقف کلمات و استفاده از TF-IDF بهبود دهید. البته، همچنین میتوانید سایر پیش پردازشهای متنی مانند stemming، lemmatization و غیره را نیز امتحان کنید تا عملکرد طبقهبندیکننده را بهبود بخشید.

ماهنامه شبکه را از کجا تهیه کنیم؟

ماهنامه شبکه را میتوانید از کتابخانههای عمومی سراسر کشور و نیز از دکههای روزنامهفروشی تهیه نمائید.

ثبت اشتراک نسخه کاغذی ماهنامه شبکه

ثبت اشتراک نسخه آنلاین

کتاب الکترونیک +Network راهنمای شبکهها

- برای دانلود تنها کتاب کامل ترجمه فارسی +Network اینجا کلیک کنید.

کتاب الکترونیک دوره مقدماتی آموزش پایتون

- اگر قصد یادگیری برنامهنویسی را دارید ولی هیچ پیشزمینهای ندارید اینجا کلیک کنید.

نظر شما چیست؟